能之想还展性坊L以太有多远我们离理2扩困

最近偶然看到一篇技术文章,让我这个研究公链多年的"老油条"都不由得眼前一亮。文章标题是《从opBNB和以太坊L2的性能差异理解Rollup的瓶颈及优化方式》,说实话这个标题看起来有点晦涩,但内容却实实在在地戳中了当前以太坊生态的痛点。两大公链的扩容困境记得2017年我刚接触区块链时,以太坊还被称为"世界计算机"。转眼7年过去,这台"计算机"的处理能力似乎仍然跟不上时代需求。BNB Chain作为后...

最近偶然看到一篇技术文章,让我这个研究公链多年的"老油条"都不由得眼前一亮。文章标题是《从opBNB和以太坊L2的性能差异理解Rollup的瓶颈及优化方式》,说实话这个标题看起来有点晦涩,但内容却实实在在地戳中了当前以太坊生态的痛点。

两大公链的扩容困境

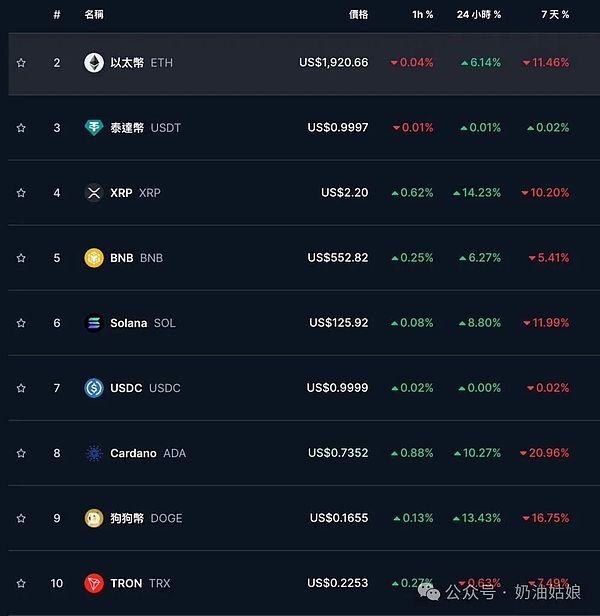

记得2017年我刚接触区块链时,以太坊还被称为"世界计算机"。转眼7年过去,这台"计算机"的处理能力似乎仍然跟不上时代需求。BNB Chain作为后起之秀也面临着同样的困境。两大公链都不得不将扩容希望寄托在L2方案上,但现实情况却令人喜忧参半。

文章中最让我震惊的是那些赤裸裸的数据对比。V神在2021年的乐观预测是L2能把交易数据压缩到11%,每秒处理1万笔交易。但现实情况呢?OP系统现在的数据压缩率只有37%,这意味着以太坊每秒最多只能处理2000笔L2交易。这个数字还不到预期的五分之一!

扩容瓶颈到底在哪里?

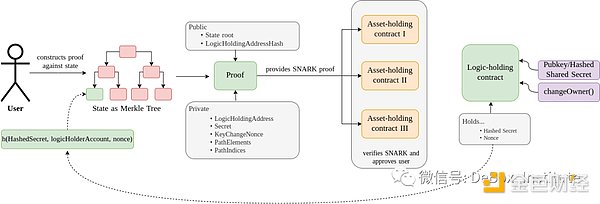

作为一个见证过多次以太坊升级的老玩家,我深知扩容问题的复杂性。文章提出了三个可能的突破方向,但每个都充满挑战:

首先,提升以太坊主网的calldata处理能力。这个想法听起来简单,但实际操作就像给正在飞行的飞机换发动机——风险太大。我清楚地记得上次伊斯坦布尔升级时,就因一个简单的EIP提案社区讨论了整整三个月。

其次,优化L2的数据压缩算法。这就像要求一个已经考了90分的学生再提高10分——越往上越难。我记得去年某L2项目宣称要将数据压缩率提高5%,结果半年过去了,这个"突破"仍然停留在白皮书上。

Layer3会是终极答案吗?

最让我感兴趣的是第三条路:Layer3。Arbitrum最近推出的L3开发套件让我想起了互联网早期的CDN技术演进。但问题在于,这种"套娃式"的扩容会不会带来新的中心化风险?就像现在的DeFi项目,虽然号称去中心化,但大部分流动性还是集中在少数几个CEX手中。

说实话,目前看来这三条路都不是完美解决方案。就像我常跟团队说的:"在区块链领域,没有银弹,只有权衡。"或许未来的解决方案会是这三者的某种组合?又或者会出现我们现在还想象不到的全新方案?

参考文章:从opBNB和以太坊L2的性能差异理解Rollup的瓶颈及优化方式

- 比特币遭遇通胀冷水澡,12万美元关口能否守住?2025-09-14 19:12

- 全球货币政策拐点已至?央行加息潮或将落幕2025-09-14 18:42

- 比特币站稳3.5万美元大关后,下一站目标在哪里?2025-09-14 17:59

- 11月6日比特币早盘:市场在玩过山车?2025-09-14 16:51